Всего трех видеороликов, снятых случайными свидетелями теракта на смартфоны, достаточно новой системе VERA для точной локализации стрелка.

Чтобы выяснить расположение вражеских снайперов или укрывшихся стрелков-террористов, ведущих огонь, нередко применяют сложные системы, включающие целый массив микрофонов, которые позволяют триангулировать источник звука. Однако использование нейросетей позволяет добиться того же на основе куда более ограниченных данных — записей, сделанных тремя обыкновенными смартфонами. О новой системе VERA (Video Event Reconstruction and Analysis, «Видеореконструкция и анализ события») сообщает пресс-релиз, распространенный Университетом Карнеги — Меллона.

VERA точно синхронизирует записи, сделанные несколькими смартфонами поблизости от места стрельбы. Ориентируясь на архитектурные детали, система реконструирует сцену вокруг места атаки и устанавливает положение на ней каждого снимающего. Затем она переходит к анализу аудиодорожек из каждого ролика. VERA ориентируется на шум пули, рассекающий воздух на сверхзвуковой скорости, и на звук самого выстрела. Задержка между ними и позволяет рассчитать положение стрелка. В качестве «опции» VERA способна по звуку выяснить и тип использованного им оружия.

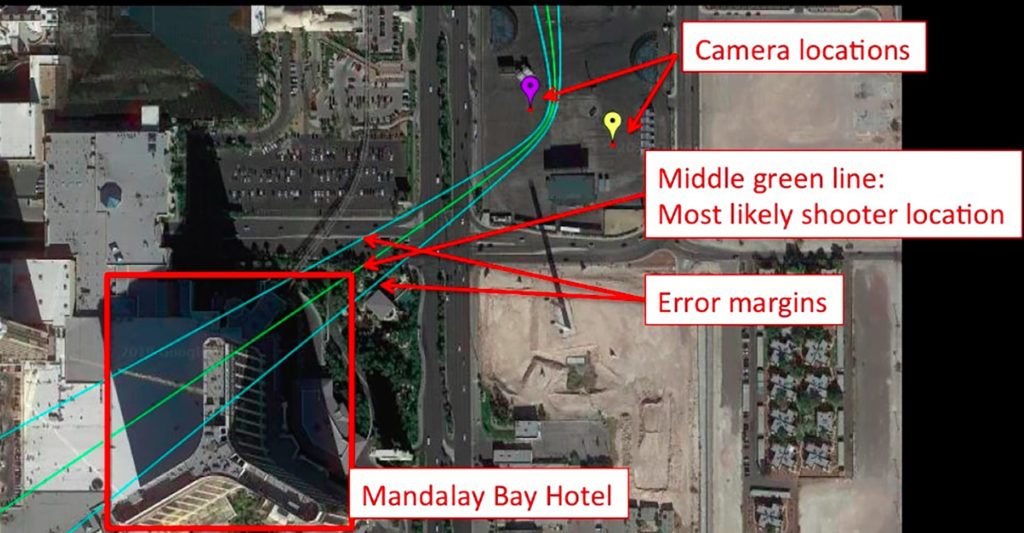

Разумеется, чем больше исходных записей система может использовать, тем точнее будут результаты работы. Однако практические испытания показали, что для достижения приемлемого результата достаточно трех видеороликов, снятых под разными углами. Используя записи теракта, совершенного в Лас-Вегасе в 2017 г., разработчики показали, что даже из этих данных VERA точно указывает положение стрелка — в северном крыле отеля «Мандалай-Бэй».

Даже с учетом максимального разброса ошибок VERA сумела локализовать стрелка в отеле в Лас-Вегасе / ©Carnegie Mellon University

VERA — программа с открытым кодом, который был представлен специалистам на прошедшей недавно во Франции международной конференции по мультимедиа. Разработана система совместно с экспертами из SITU Research — акустиками, архитекторами, баллистиками.

Источник: Naked science