Учені створили математичний тест, який поки що не проходить жоден штучний інтелект.

Схоже, що до технологічної сингулярності нам ще далеко. Дослідники з організації Epoch AI представили новий математичний бенчмарк FrontierMath, з яким поки не можуть впоратися навіть найбільш просунуті моделі штучного інтелекту, інформує УНІАН.

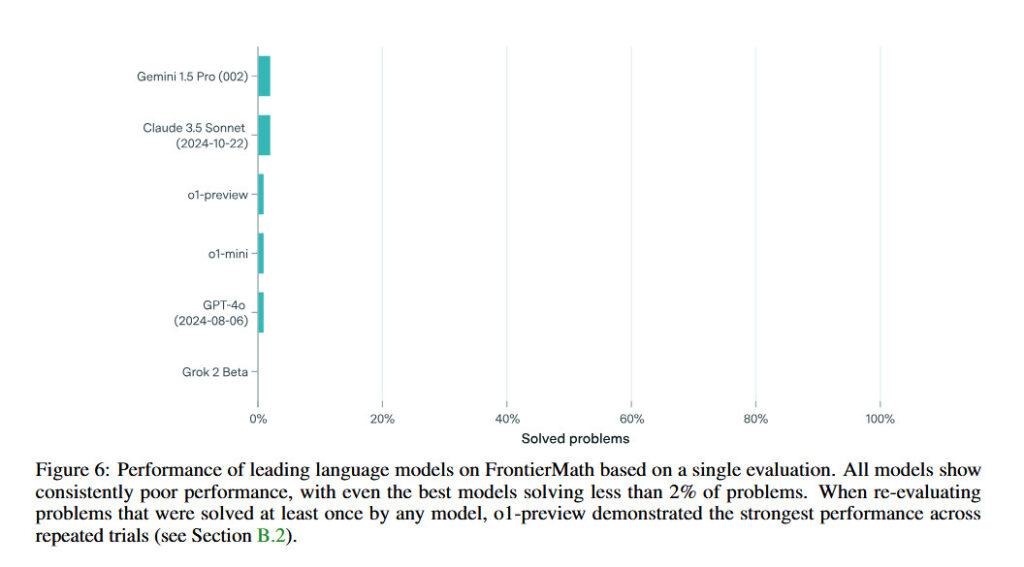

FrontierMath містить у собі безліч найскладніших математичних виразів. Моделі Claude 3.5 Sonnet, GPT-4o, o1-preview і Gemini 1.5 Pro вирішують менше двох відсотків завдань. При цьому під час тестування у ШІ є повний доступ до середовища Python для обчислень і дебагінгу. Для порівняння, у старіших бенчмарках, на кшталт GSM8K або MATH, моделі правильно розв’язують понад 90% рівнянь.

Головною особливістю FrontierMath є те, що задачі звідти раніше ніде не публікувалися, тобто нейромережі не могли заздалегідь навчитися розв’язувати такі вирази.

Як видно на графіку, найпродуктивнішою моделлю виявилася Gemini 1.5 Pro, але навіть вона змогла розв’язати менше ніж 2% завдань. Головним аутсайдером стала LLM від Ілона Маска Grok 2 Beta, яка зараз тестується у Twitter, вона не змогла розв’язати жодного рівняння.

Для створення тесту FrontierMath було задіяно 60 математиків з університетів по всьому світу. Завдання в бенчмарку охоплюють безліч галузей, включно з теорією чисел і алгеабраїчною геометрією. У фахівців може піти кілька днів, щоб вирішити одне завдання з тесту.